実はGoogle colaboratoryでは複数の種類のGPUが使用できます。

しかし、通常は自動的に割当が行われるため、我々が意識することはありません。

でも、どうしても前回実行した結果と同じ条件で使用した時など、GPUを指定したくなります。

という事で、今回は使用するGPUを変更する方法をご紹介したいと思います。

Google colaboratoryで使用するGPUを変更する方法

GPUを変更する方法と言いましたが、実は我々がGPUを指定する事は出来ません。

Googleさんによって自動的に割り当てられます。

しかし、割当はランダムなので、GPUの再指定を促す操作を行い、使用したいGPUに割り当たるのを待つという方法を試してみます。

では早速GPUを変更してみましょう!

まず今割当られているGPUを確認してみましょう。

Google Colaboratoryを起動して以下のコードを実行して下さい。

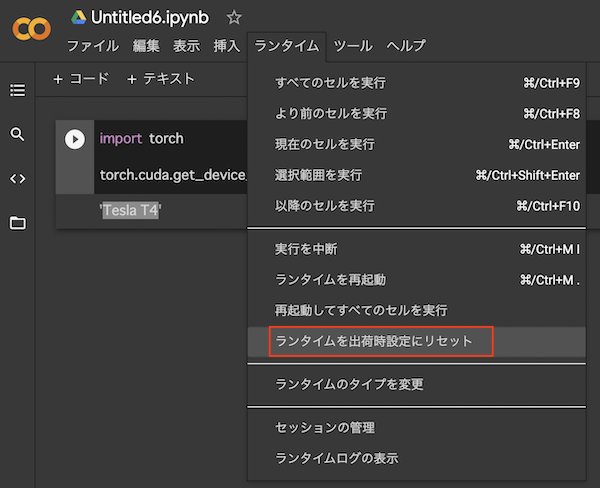

import torch torch.cuda.get_device_name(0)

‘Tesla T4’など、GPUの種類が表示されます。

もし表示されたGPUが自分が使用したいものでない場合、

[ランタイム]→[ランタイムを出荷時設定にリセット]でリセットを行って下さい。

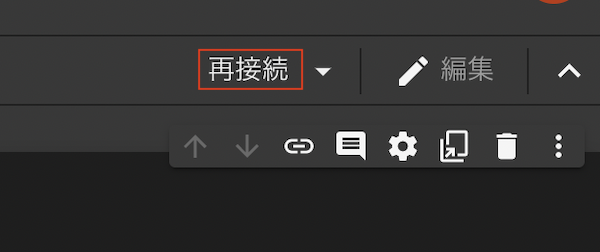

そして、右上あたりに「再接続」の表示が出てくるのここをクリックして下さい。

5〜6秒するとステータスが接続済みとなりますので、そうしたら改めてGPUを確認するコードを再度実行してみて下さい。

どうですか、GPUの種類は変わりましたか?

この記事を書いている時点で、Googlel Colaboratoryで使用できるGPUの種類は以下のとおりです。

- Tesla T4

- Tesla K80

- Tesla P100-PCIE-16GB

GPUの割当はランダムなので、一度でつかいたGPUが割当られる保証はありません。

もし使いたいGPUと異なる場合は再度ランタイムをリセットして確認してみて下さい。

まとめ

今回は、Googlel ColaboratoryでGPUを変更する方法をご紹介しました。

簡単でしたね。

尚、GPUのスペック上、Tesla P100-PCIE-16GBが一番はやいので、これにあたったらラッキーです。

機械学習で学習時間を短くしたい人は、’Tesla P100-PCIE-16GB’ にあえて変更してから実行すると、いつもより早く処理が終わるかもしれません。

是非試してみて下さい。